COMPUTER VISION: USE CASES SOWEIT DAS ELEKTRONISCHE AUGE REICHT

09.05.2022 // Max Uppenkamp

(c) Getty Images - vchal

Wer wünscht sich nicht manchmal ein drittes Auge, das den 3D-Drucker, den Hund im Garten, oder vielleicht auch nur den Kuchen im Ofen im Auge behält? Ein Kollege fragte mich vor einiger Zeit sogar, ob eine Künstliche Intelligenz (KI) nicht sogar automatisch seine Katzenklappe verriegeln könnte, wenn seine Katze eine Maus anschleppt. Damals musste ich ihn leider enttäuschen, mittlerweile bin ich aber deutlich optimistischer, was die Fähigkeiten, und vor allem die Praxistauglichkeit von Computer-Vision-Modellen betrifft.

Die beeindruckenden Fortschritte der letzten Jahre erlauben nicht nur den Einsatz stärkerer Modelle auf schwächerer Hardware, sondern reduzieren außerdem stark den mit dem Trainingsvorgang verbundenen Aufwand. Dementsprechend hat das Thema Bildverarbeitung, und im speziellen die Objekterkennung, für unser INFORM DataLab erheblich an Bedeutung gewonnen. Im Rahmen der Machine-Learning-Studie vom INFORM DataLab zusammen mit der Computerwoche, IDG Research Services und Lufthansa Industry Solutions spiegelt sich dieser Trend sehr deutlich wider. Daher möchte ich einige dieser Ergebnisse aufzeigen und in Kontext setzen.

STUDIENERGEBNISSE: INTELLIGENTE BILDVERARBEITUNG GEWINNT AN BEDEUTUNG

Schauen wir uns beispielsweise die Top 5 für umgesetzte Machine-Learning- und KI-Projekte an, bieten alle genannten Use Cases – abgesehen von Supply-Chain-Optimierung großes Potential für Computer-Vision-Applikationen (53.8% Qualitätssicherung in Produktion, 43.8% Fehlerreduzierung, 40.2% Prozessautomatisierung, 36.7% Automatisierte Vorgangsbearbeitung).

Hier ein paar Ideen:

- Qualitätssicherung: Defekterkennung auf Röntgenaufnahmen von Schweißnähten

- Fehlerreduzierung: Detektion von fehlerhaft durchgeführten Arbeitsgängen

- Prozessautomatisierung: Lokalisierung von Früchten für Ernte-Robotik

- Vorgangsbearbeitung: Automatisierte Klassifikation von Schadensbildern im Versicherungswesen

Wenn es also nicht an Anwendungsfällen mangelt, und noch dazu ca. 37% der Studienteilnehmer angeben, die automatisierte Bildanalyse bereits in KI- und ML-Projekten einsetzen und 22% deren Einsatz bei zukünftigen Projekten plant: Was genau verzögert dann die flächendeckende Adoption dieser Technologie?

BILDVERARBEITUNG VS BILDVERARBEITUNG

Die Idee einer automatisierten Erkennung von Objekten in Bildern ist alles andere als neu. Im direkten Kundenkontakt höre ich regelmäßig von persönlichen Erfahrungen mit dem Thema Bildverarbeitung, die oft Jahrzehnte zurückliegen und die meist bestenfalls in durchwachsener Erinnerung geblieben sind. Logischerweise wird dem Thema Computer Vision dadurch oft mit einer gesunden Portion Zurückhaltung begegnet. An dieser Stelle kann ich gar nicht deutlich genug machen, wie wenig moderne Deep-Learning-Methoden mit der klassischen, feature-basierten Objekt-Lokalisierung gemein haben.

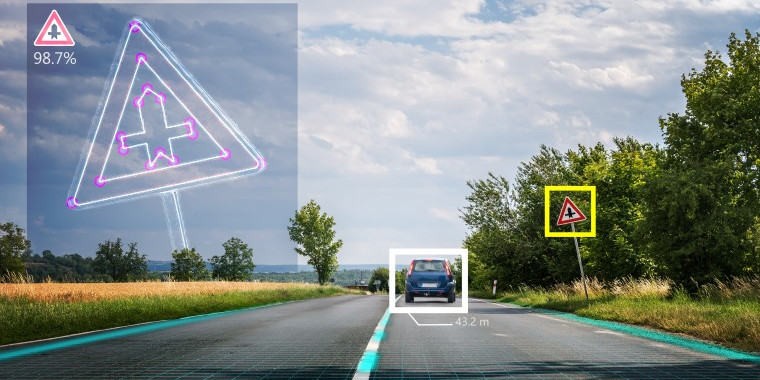

Stellen wir einmal die beiden Herangehensweisen am Beispiel der Fahrzeugerkennung gegenüber, die vor allem im Bereich des autonomen Fahrens zur Anwendung kommt: In der klassischen Bildverarbeitung verwendet ein Experte sehr viel Zeit darauf, zu definieren, was ein Fahrzeug ist, bzw. wodurch es sich in seiner wieder erkennbaren Geometrie auszeichnet. Dabei gilt es, die Definition so generisch und robust wie möglich zu halten, um eine möglichst große Vielfalt von Modellen abzudecken. Hierbei ist nie garantiert, dass der resultierende Algorithmus auch bei Störeinflüssen wie zum Beispiel abweichenden Belichtungsverhältnissen korrekt agiert.

Für das Training eines erheblich leistungsfähigeren Deep-Learning-Modells ist es hingegen ausreichend, eine Reihe von Fahrzeug-Bildern mit sogenannten „Bounding Boxes“ zu annotieren. Auf gut Deutsch heißt das, dass mit der Maus ein Kasten um die in den Bildern erkennbaren Fahrzeuge gezeichnet wird – eine Arbeit, die keine besonderen Kenntnisse erfordert. Wie viele Bilder auf diese Weise bearbeitet werden müssen, hängt ganz von der Komplexität des Anwendungsfalls ab. Üblich sind Mengen von 300 bis einigen Tausend Bildern, wobei anzumerken ist, dass die Forschung in der jüngeren Vergangenheit stark an der Verringerung dieser Zahlen arbeitet. Tatsächlich reichen in den jüngsten Modellen oft bereits ein Dutzend Bilder für ein robustes Modell, was den Trainingsaufwand erheblich reduziert.

COMPUTER VISION WIRD AGIL

Dieser Wandel der Technologie bringt auch eine neue Art des Umgangs mit und der Herangehensweise von Computer-Vision-Projekten mit sich.

Ein „durchschnittliches“ Computer-Vision-Projekt kann mittlerweile innerhalb von wenigen Wochen realisiert werden. Hierbei entfällt immer noch ein Großteil der Zeit auf die Erhebung und Vorverarbeitung von Bildmaterial. Denn es gilt ein möglichst repräsentatives Sample der Realität zu generieren. In der Praxis heißt das, dass wiederholt und unter wechselnden Bedingungen Bildmaterial aufgenommen werden muss. Sobald ein zufriedenstellendes Dataset zustande gekommen ist, kommen Supersampling Methoden zum Einsatz, die aus den vorliegenden Bildern intelligent weitere Trainingsbilder generieren, beispielsweise durch Rotation, Projektion oder simple Spiegelung. Auf Basis des dadurch erweiterten Datasets wird schlussendlich ein gezielt ausgewähltes Modell trainiert.

So weit, so gewöhnlich.

Im Unterschied zur klassischen, feature-basierten Objekterkennung bleibt diese Lösung aber weiterhin plastisch. Sollten sich Gegebenheiten ändern oder Randfälle auftun, die das System nicht abdeckt, kann hier durch den Endanwender gezielt nachgearbeitet werden. Dieser DIY-Aspekt wird Unternehmen laut unserer Studie immer wichtiger: über 78% der Befragten geben an, zumindest teilweise bereits inhouse Machine-Learning-Lösungen zu entwickeln.

Ein derart aufgebautes System wächst und lernt kontinuierlich mit und muss nur sehr selten vollständig erneuert werden. Dieser Mechanismus erlaubt es uns außerdem, Lösungen in iterativen und inkrementellen Schritten zu entwickeln, vom Single-Case Proof-of-Concept bis hin zur flächendeckenden Endanwendung.

Dieser Artikel ist im Original auf dem INFORM DataLab Blog erschienen.

ÜBER UNSERE EXPERT:INNEN

Max Uppenkamp

Data Scientist

Max Uppenkamp ist seit 2019 als Data Scientist bei INFORM tätig. Nachdem er zuvor im Bereich Natural Language Processing und Text Mining tätig war, beschäftigt er sich nun mit der Machine-Learning-gestützten Optimierung von Prozessen. Neben der Begleitung von Kundenprojekten setzt er die gewonnenen Erkenntnisse in praxisorientierte Produkte und Lösungen um.